אם הגעתם למאמר הזה, כנראה שאתם מבינים דבר או שניים ב-SEO. אבל גם אם אלו הצעדים הראשונים שלך בעולם קידום האתרים אני אנסה להסביר בצורה מדויקת ופשוטה מהי החשיבות של robots.txt, ואיך להגדיר אותו נכון.

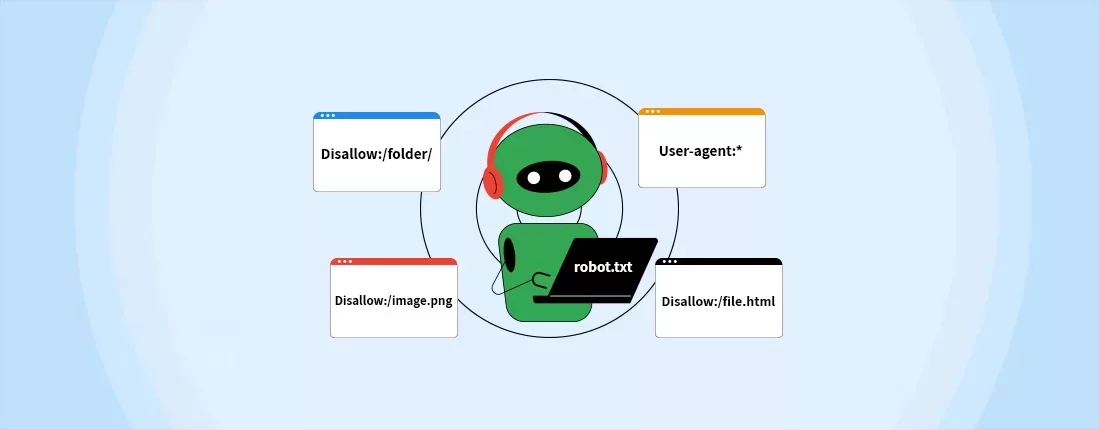

אם אנסה להסביר במשפט אחד מה זה robots.txt, אז מדובר במסמך שכל המהות שלו היא הנחיות עבור מנוע החיפוש. זה הדבר הראשון שמנוע החיפוש "יחפש" כאשר יגש לסרוק את האתר שלכם. באמצעות מסמך robots.txt יש לכם אפשרות לבחוראילו דפים תרצו שגוגל יסרוק ואיזה דפים לא.

במאמר הבא ניכנס לעומק של robots.txt, אציג לכם איך המסמך נראה, אסביר למה הוא יכול לשרת אתכם, מתי כדאי להשתמש בו והכי חשוב, נדבר על הפרקטיקה, ממה המסמך מורכב ואיך בונים אותו בצורה איכותית ומדויקת.

למה robots.txt חשוב בתהליך SEO?

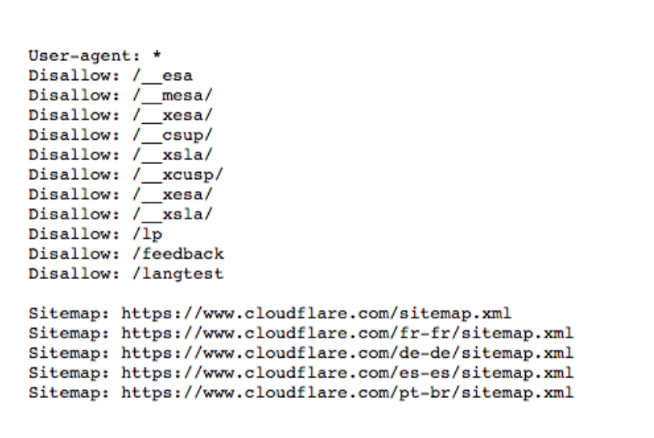

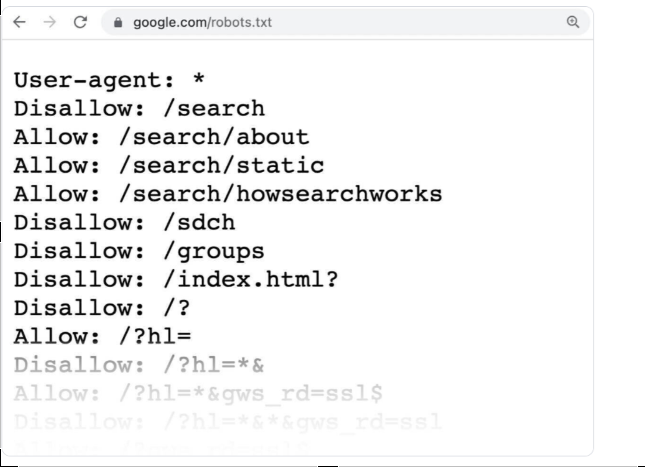

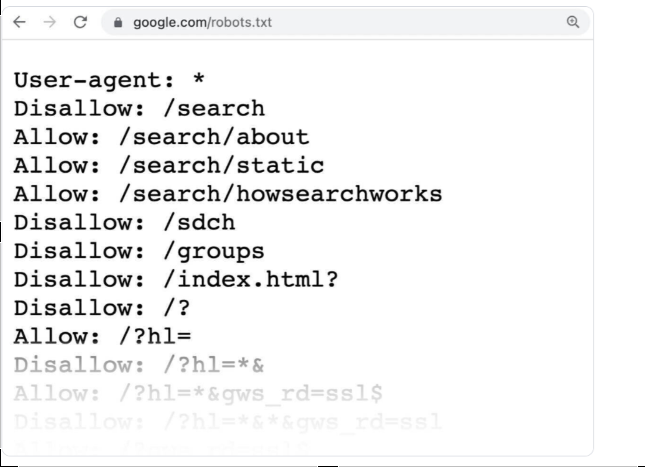

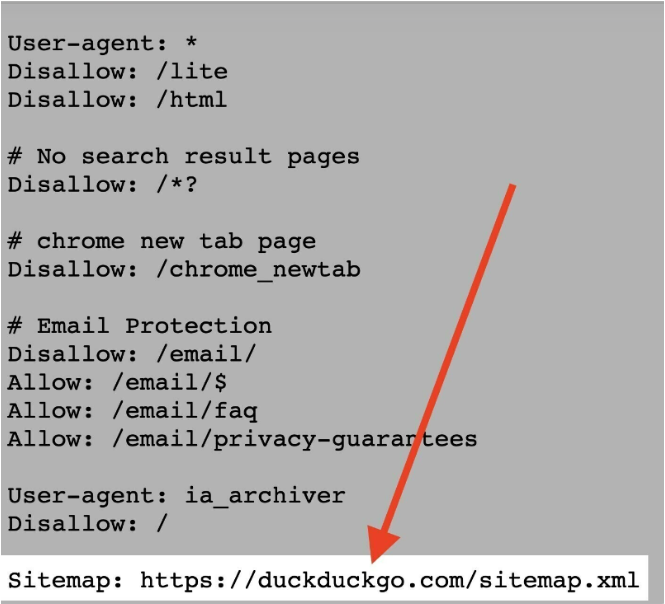

כאשר בוחנים במראה ראשוני את מסמך robots.txt, למי שלא מתכנת או מתעסק עם שפת תכנות, זה מרגיש קצת כמו סינית. מסמך מאיים שנראה חלק משורות קוד מבלבלות. אבל אם תתנו לו הזדמנות, תגלו שבסופו של דבר מדובר במסמך די פשוט שנראה בערך ככה:

אפשר לראות כי יש כאן חלוקה די ברורה בין מפת האתר, לבין ALLOW DISALLOW ועוד. במילים אחרות, כל שורה כאן היא בעצם הנחיה עבור מנוע החיפוש, נסו לדמיין את זה כמו "מכתב" בו אתם כותבים למי הוא ממוען, מה אתם רוצים להגיד לו ואיך אתם רוצים להנחות אותו לפעול.

באופן הזה נוכל להגדיר מה שנרצה שמנועי החיפוש יסרקו, לבין מידע שאנחנו לא מעוניינים שיסרקו.

מתי נשתמש בקובץ robots.txt?

מדייק את "תקציב" הסריקה שגוגל נותן לאתר שלנו

מה הכוונה? במילים אחרות, גוגל מקציב כמות סריקה מסוימת עבור כל אתר, שבזמן הזה הוא בעצם בודק את הדפים שבו ומאנדקס אותם. כמובן שזה מאוד משתנה ותלוי בגודל האתר וכמות המידע שיש בו, כמו הקישורים שיש בו וכד'. הרי תסכימו איתי שלא הגיוני שגוגל יקצה אותה כמות דפים לסריקה עבור אתר קטן ואתר גדול.

תקציב הסריקה חשוב מאוד לבעלי אתרים או מומחי SEO, כי אם כמות הדפים באתר חורגת מתקציב הסריקה של האתר, יהיו דפים באתר שבעצם לא מתווספים לאינדקס של גוגל, לכן הם גם לא יוצגו בתוצאות החיפוש. המשמעות של זה היא כבירה, הרי אם לא תופיעו בחיפושים, יהיה לכם מאוד קשה להוביל גולשים לעמודים האלו. לכן, אני ממליץ מאוד להשתמש גם במפת אתר, וזאת על מנת להגדיר למנועי החיפוש מה חשוב לכם שהם יסרקו ויציגו בחיפושים ומה לא.

לכן, בדיוק במקרים כאלו, חשוב ומומלץ להשתמש במסמך robots.txt ודרכו, לחסום דפים שמבחינתכם לא רלוונטים.

חסימת דפים כפולים או לא ציבוריים

כמו שכבר כתבתי כאן, אנחנו ממש לא חייבים לאפשר למנועי החיפוש לסרוק כל עמוד באתר שלנו, בעיקר בגלל שלא כל העמודים באתר שלכם צריכים דירוג. לפעמים יש באתרים דפים כפולים או משוכפלים, דפים המיועדים לשימושים פנימיים ולא מיועדים לשימוש של גולשים חיצוניים. דוגמא נוספת היא עמודים טכניים, כמו עמודי התחברות למערכת. הדפים מהסוג הזה חייבים להיות קיימים באתר שלכם, אבל לא חייבים להיסרק.

הסתרת מסמכים ותמונות

לפעמים יש לנו מידע באתר, שלא בהכרח נרצה להציג כמו קבצי PDF, תמונות סרטונים וכדומה. אם לא תרצו שהמידע הזה יופיע תחת חיפוש של תמונות, מסמכים או סרטונים בגוגל, מסמך robots.txt הוא בדיוק מה שאתם צריכים.

תוכלו בעצם לייצר פנייה לבוט סריקת התמונות של גוגל ולבקש ממנו לא להציג את הקבצים האלו.

איך robots.txt עובד בכלל?

גוגל עובד על אלגוריתם, שחלק הארי בו הוא סריקת אתרים ואינדוקס שלהם לפי מילות חיפוש שונות, קטגוריות שונות ותחומי עניין שונים. קבצי robots.txt מייצרים סוג של שיחה עם מנועי החיפוש ומספרים לו מה מכתובות האתר שלכם (URL) אפשר לסרוק ואילו מהעמודים אין צורך לסרוק.

הדרך למצוא את robots.txt באתר שלכם

אם בדיוק התחלתם לעבוד על אתר חדש, או שהייתם רוצים לבדוק האם קיים אצלכם בכלל מסמך robots.txt, תוכלו לעשות את זה בדרך פשוטה ונוחה. קובץ robots.txt מתארח בשרת שלכם, ממש כמו כל קובץ או מסמך אחר שיש באתר שלכם.

כדי לבדוק את קובץ ה-robots.txt הקיים אצלכם, כל מה שאתם צריכים לעשות זה להקליד בשורת החיפוש את כתובת האתר המלאה של דף הבית והמשך שלה להוסיף robots.txt/. לאחר מכן הקליקו אנטר על מנת להתקדם לחיפוש המסמך, לדוגמא: https://www.seolinks.co.il/robots.txt.

מבנה מסמך robots.txt

בניית מסמך robots.txt היא לא ממש מדע טילים, אבל בהחלט דורשת הבנה בסיסית, ובהמשך המאמר אני אסביר לכם בדיוק איך לבצע זאת.

קובץ robots.txt מורכב מכמה אלמנטים:

"הנחיות" \ "כללים".

"המשתמש" – מי אנחנו רוצים שיבצע או לא יבצע את הפעולה.

"אפשר" \ "אל תאפשר" את הצגת המידע.

סוכן משתמש

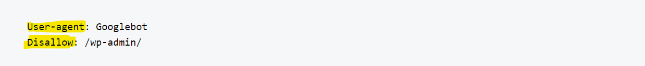

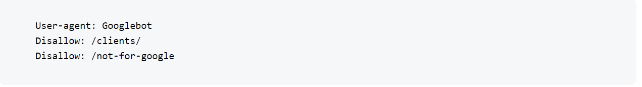

הוראת המשתמש סוכן, היא בעצם השורה הראשונה של כל בלוק הנחיות, באמצעות הפנייה הזאת, אנחנו בעצם אומרים למי אנחנו מדברים, כלומר למי ההנחיות הללו מופנות. לכן, אם אנחנו רוצים לסמן לגוגל לא לסרוק את דף הניהול שלנו בוורדפרס (לדוגמא), הנחייה שלנו צריכה להתחיל באופן הזה:

כדאי לזכור שלמנועי החיפוש יש מספר סורקים, בהם הם משתמשים לאינדקס הרגיל והם תמיד יחפשו את ההנחיות הספציפיות ביותר שהם יוכלו למצוא.

אל תסרוק לי – DISALLOW

כחלק מההנחיות, אנחנו בעצם אומרים למנועי החיפוש מה לא לעשות. כלומר, אתם יכולים לבנות עמודים שלמים בהם כתוב מה אתם לא מעוניינים שמנוע החיפוש ירוק ויציג לגולשים חיצוניים. במידה ושורת ה-"איסורים" שלכם ריקה, המשמעות היא שאתם מאפשרים למנועי החיפוש לסרוק ולאנדקס את כל האתר שלכם, ללא יוצאים מן הכלל.

הנחיות כמו "אפשר" או "אל תאפשר" יכולות להיות גם עם אותיות קטנות וגם עם אותיות גדולות, זה לא ממש משנה איך תבנו את זה, מה שכן, חשוב שתהיה אחידות לאורך המסמך כולו.

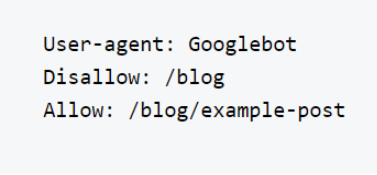

תסרוק לי! ALLOW

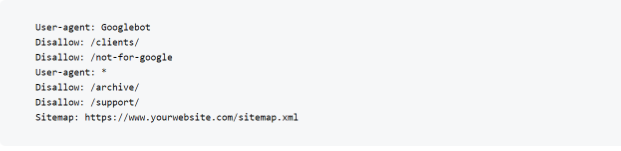

בניגוד להנחיות "אל תאפשר" הנחיות "תאפשר" מאפשרות למנועי החיפוש לסרוק את העמודים באתר שלכם, דפים ספציפיים שאתם בוחרים ועוד. יתרה מזאת, גם אם יש לכם תיקייה שאסורה לסריקה, אתם יכולים לבחור שרק מסמך אחד מתוכה יהיה מאושר לסריקה. איך זה נראה מבחינת מסמך ה-robots.txt?

אם תסתכלו על זה, מדובר בתהליך מאוד פשוט. בשורה הראשונה אנחנו מגדירים למי ההנחיות מיועדות, בחלק השני אנחנו מגדירים את ה-URL של התיקייה אותה אנחנו רוצים לחסום ובשורה מתחת, אנחנו מאפשרים סריקה של URL אחד מתוך התיקייה הזאת.

מפות אתר

אז אתם בטח מכירים את את מפות האתר. אז חלק ממסמך ה-robots.txt כולל גם הנחיות למפות האתר. הכוונה היא שההנחיות האלו בעצם אומרות למנועי החיפוש איפה למצוא את מפת ה-XML שלכם.

קבצי מפות האתר, ברוב המקרים כוללות בתוכן את כל הדפים שאתם רוצים שגוגל יסרקו ויוסיפו לאידקס, על מנת שתוכלו להופיע בתוצאות החיפוש. עמוד שלא נמצא בתוך מפת האתר, לא מוצג בתוצאות חיפוש. כדי להקל על מנוע החיפוש, כדאי שתוסיפו את הנחיות למפת האתר:

איך בונים קובץ robots.txt

אז אחרי שהסברתי מה החשיבות של הקובץ וגם מה הוא כולל, בואו נרד לפרקטיקה. איך בונים קובץ robots.txt?

בניית מסמך robots.txt

אז השלב הראשון הוא לפתוח מסמך מסוג txt (באמצעות דפדפן אינטרנט או עורך טקסט אחר). לאחר מכן, תקראו למסמך בשם robots.txt, על מנת שמנועי החיפוש יוכלו לזהות את המסמך.

בניית הנחיות

קובץ robots.txt מורכב מקבוצה אחת או יותר של הנחיות. לכל קבוצה מספר שורות של הוראות, כאשר כל קבוצה קודם כל מתחילה ממי ה-User agent שלה. כמו שאמרנו קודם, זאת בעצם ההתייחסות לאיזה מנוע חיפוש אנחנו "מדברים".

בחלק השני, אנחנו בעצם נגדיר לאילו ספריות או דפים אותו סוכן יכול לגשת ואילו ספריות וקבצים הוא לא יכול לגשת. בנוסף לכך, מומלץ גם לשלב מפת אתר, על מנת להדגיש לאותו סוכן איזה עמודים באתר הכי חשובים לנו.

שימו לב! הסורקים מתעלמים משורות שלא תואמות למבנה. בסופו של דבר מדובר על רובוט ואלגוריתם, אם לא תדברו אליו בשפה שהוא מבין, בעתם לא תעשו כלום ולא תהיה לכך שום השפעה.

אם אתם מעוניינים שההנחיות יהיו רלוונטיות לכלל מנועי החיפוש, אתם יכולים להשתמש ב-*. המשמעות של * במסמך robots.txt זה בעצם הכל \ כולם. לאחר שתסיימו עם הסוכן הראשון, במקרה הזה גוגל, תוכלו ללחוץ פעמיים על מקש ENTER ולייצר קבוצה חדשה של הנחיות, המיועדות לסוכן אחר. בנוסף לכך, חשוב שלא תאפשרו סריקה של עמודים שמבחינתכם הם לא ממש רלוונטיים וסתם עלולים לבזבז לכם את תקציבי הסריקה המוקצים לכם, כמו לדוגמא עמוד תמיכה. בנוסף לכך, בסוף ההנחיות כדאי ומומלץ לשלב הנחיות לעמוד XML מפת אתר.

העלאת המסמך

זהו, הקובץ מוכן ומזומן וכל שנותר לכם הוא להעלות אותו לאתר שלכם ולהפוך אותו לזמין עבור מנועי החיפוש. העלאת קובץ robots.txt תלויה במבנה הקבצים של האתר שלכם והאירוח שלכם. על מנת להעלות את הקובץ, אתם צריכים להתחבר לשרת שלכם, שם להתחבר לתוך מנהל הקבצים והתחברות לתיקיית ה-FTP שיושבת בתוך השרת. חשוב לוודא לפני שמירת המסמך כי לא קיים מסמך בשם robots.txt.

בדיקה בדיקה

באופן כללי אני ממליץ לכם לאחר כל פעולה שסיימתם, לבצע בדיקה ולראות שהכל תקין והתקבל בצורה טובה. אז גם כאן, לאחר שעשיתם את כל הפעולות הנדרשות, הגיע הזמן לבדיקות. הבדיקה הראשונה שאני ממליץ לכם לעשות, זה לוודא שהמסמך שבניתם הועלה כמו שצריך לשרת והוא נגיש.

כדי לעשות את זה, כל מה שצריך לעשות זה לבדוק באמצעות הדפדפן את המסמך, כמו שלימדתי אתכם קודם:) פשוט להוסיף robots.txt בסיומת ה-URL של האתר שלכם ושם תוכלו לראות את המסמך.

אם אתם רואים את קובץ ה-robots.txt שלכם עם התוכן שהוספתם, אתם מוכנים לבדוק את המסמך גם ב-Google console באמצעות פונקציה ייעודית לבדיקת מסמכי robots.txt.

דברים שחשוב לזכור בבניית מסמך robots.txt

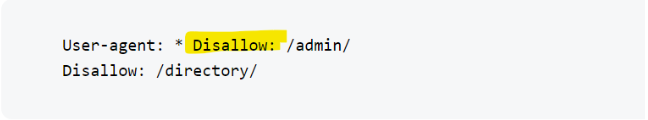

בנו את המסמך כל שכל שורה תהיה בנפרד

מסמך HTML, או מסמך הנחיות כללי שאמור להנחות תוכנה כלשהי, צריך להיות בנוי לפי שורות שונות ולא לערבב הנחיות שונות באותה שורה כמו בדוגמה הזאת:

בנו כל הנחיה בנפרד

אם לא תבנו את המסמך עם ההפרדות הנכונות או בצורה הנכונה, מנועי החיפוש לא יבינו מה אתם רוצים ולא יפעלו לפי ההנחיות שאם רוצים.

לכן, חשוב מאוד לבנות את המסמך כך שלכל סוכן יהיה הנחיות ייעודיות עבורו, או לסמן * את ההנחיות עבור כלל הסוכנים.

השתמש בתווים כלליים להנחיות כלליות

אם אתם מעוניינים להכיל את ההנחיות על כלל הסוכנים, תוכלו להשתמש ב* ותוכלו בשורות הבאות לסייג אלמנטים שאתם לא מעוניינים שיסרקו, או תכנים שאתם לא מעוניינים שסוכן ספציפי יסרוק.

יש לכם הערות פנימיות למסמך? תשתמשו ב-#

אם אתם רוצים להוסיף טקסט לעמוד שלכם אבל לא מעוניינים שמנוע החיפוש בסריקת האתר יתייחס בכלל לטקסטים האלו, תוכלו להשתמש ב-#. סימן ההאש בעצם מסמן למנוע החיפוש לא לבצע סריקה כלל לטקסט הזה, אלא פשוט להתעלם ממנו.

השתמשו בקבצים שונים ל-Subdomains שונים

אם יש לכם תתי דומיינים, כדאי מאוד לפצל בהתאמה גם את קבצי ה-robots.txt. הסיבה היא שהקבצים האלו שולטים רק בהתנהגות הסריקה בתת דומיין בו הם מתארחים (הרי הכל יושב בשרת). לכן, במידה ואתם צריכים שליטה בסריקת תת דומיין, אני ממליץ גם לפצל את הקבצים בהתאמה.